attention完整版_attention完整版原唱

*** 次数:1999998 已用完,请联系开发者***

lisa跳舞attention完整版

国内首个非Attention大模型发布!训练效率是Transformer的7倍作者 | 李水青编辑 | 心缘智东西1月25日报道,昨日,岩山科技旗下创企岩芯数智(Rock AI)推出国内首个非Attention机制的大模型Yan,也是业内少有的非Transformer架构大模型。岩芯数智CEO刘凡平介绍,Yan是一个通用大语言模型,拥有相较于同等参数Transformer的7倍训练效率、5倍推理...

lisa舞蹈attention完整版

attention 完整版

●ω● 岩芯数智自研国内首个非Attention机制大模型,无损提速7倍1月24日,在上海岩芯数智人工智能科技有限公司“新架构,新模力”大模型发布会上,岩芯数智正式发布了国内首个非Attention机制的通用自然语言大模型——Yan模型。作为行业内少有的非Transformer大模型,Yan模型用全新自研的“Yan架构”代替Transformer架构,用百亿级参数达成千...

attention中文版完整版

《attention》

岩芯数智自研!国内首个非Attention机制大模型,来了1月24日,在上海岩芯数智人工智能科技有限公司“新架构,新模力”大模型发布会上,岩芯数智正式发布了国内首个非Attention机制的通用自然语言大模型——Yan模型。作为行业内少有的非Transformer大模型,Yan模型用全新自研的“Yan架构”代替Transformer架构,用百亿级参数达成千...

attention原版免费

attention在线

不用GPU也能训练大模型?这家AI初创企业首推非Attention机制大模型《科创板日报》1月30日讯(记者 张洋洋) 在Transformer占大模型架构主流的背景下,国内一家AI初创企业正在试图撼动前者的主导地位。 近期,岩山科技旗下的AI初创公司岩芯数智发布了国内首个非Attention机制的大模型Yan,这是业内少有的非Transformer架构大模型。 Transformer是一...

attention免费

●▂●

摆脱Transformer依赖?这家AI初创公司推出国内首个非Attention机制大...正式发布了国内首个非Attention机制的通用自然语言大模型——Yan模型。作为行业内少有的非Transformer大模型,Yan模型用全新自研的“Yan架构”代替Transformer架构,用百亿级参数达成千亿参数大模型的性能效果——记忆能力提升3倍、速度提升7倍的同时,实现推理吞吐量的5倍提...

产品经理常用的100种思维模型——汇总篇「4」产品经理常使用的思维模型有哪些?这篇文章里,作者做了梳理,分享了AIDA模型、STP营销理论、安索夫矩阵等内容,一起来看看吧。一、AIDA营销模型AIDA模型是一种营销沟通模型,用于描述消费者从接触外界营销信息到完成购买行为的过程。A – Attention(引起注意):吸引目标受众的...

o(╯□╰)o 岩山科技:岩芯数智团队正研发Yan 2.0大模型 将融合文字、音频、视频...中国财富通2月21日 - 岩山科技(002195)在互动平台上表示,公司始终关注AI领域的最新进展,并持续进行技术创新。2024年1月,公司旗下岩芯数智已在上海发布了完全自主研发的Yan 1.0大语言模型,该模型是国内首个非Attention机制的大模型,同时也是国内领先的非Transformer架构大模型...

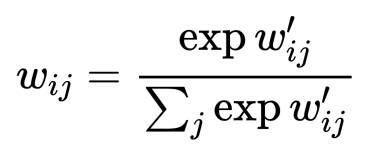

●﹏● Transformer神经网络:GPT等AI大模型的基石Transformer神经网络模型仅基于注意机制(Attention Mechanisms),完全摒弃了循环和卷积的结构,以其独特的自注意力机制和并行计算能力,解决了传统模型在处理长序列时的长距离依赖问题和计算效率问题,从而在各种NLP任务中取得了优异的性能。本文既是深度学习系列的最后一篇,也...

̄□ ̄||

白敬亭C位事件发酵,个人账号持续掉粉,被爆不是第一次换衣服eliminatinganyconcernofappearingattention-seeking. BaiJingtian'sactionstriggeredarippleeffect,leadingtoadeclineinfollowersonhissocialmediaaccounts.Netizensdelveddeeper,uncoveringpreviousinstanceswhereBaiJingtianworedifferentoutfitsfromco-stars,eveninunrelatedevents.Thecontro...

+▂+

聪明的大脑从小开始——专注力训练3-10岁高难度益智书籍开发幼儿图书作者:岩哥优惠资讯随着社会的发展,人们越来越意识到教育的重要性,而幼儿教育则更是备受关注。幼儿时期是大脑发育最为迅速的时段,也是学习基础知识和技能的关键时期。而专注力则是孩子学习和成长不可或缺的品质之一。专注力(Attention)是指个体对外界刺激进行选择、集中和维...

坚果加速器部分文章、数据、图片来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知删除。邮箱:xxxxxxx@qq.com

上一篇:attention完整版原唱

下一篇:attention完整版