attention机制_attention机制

*** 次数:1999998 已用完,请联系开发者***

attention机制详解

岩芯数智自研!国内首个非Attention机制大模型,来了1月24日,在上海岩芯数智人工智能科技有限公司“新架构,新模力”大模型发布会上,岩芯数智正式发布了国内首个非Attention机制的通用自然语言大模型——Yan模型。作为行业内少有的非Transformer大模型,Yan模型用全新自研的“Yan架构”代替Transformer架构,用百亿级参数达成千...

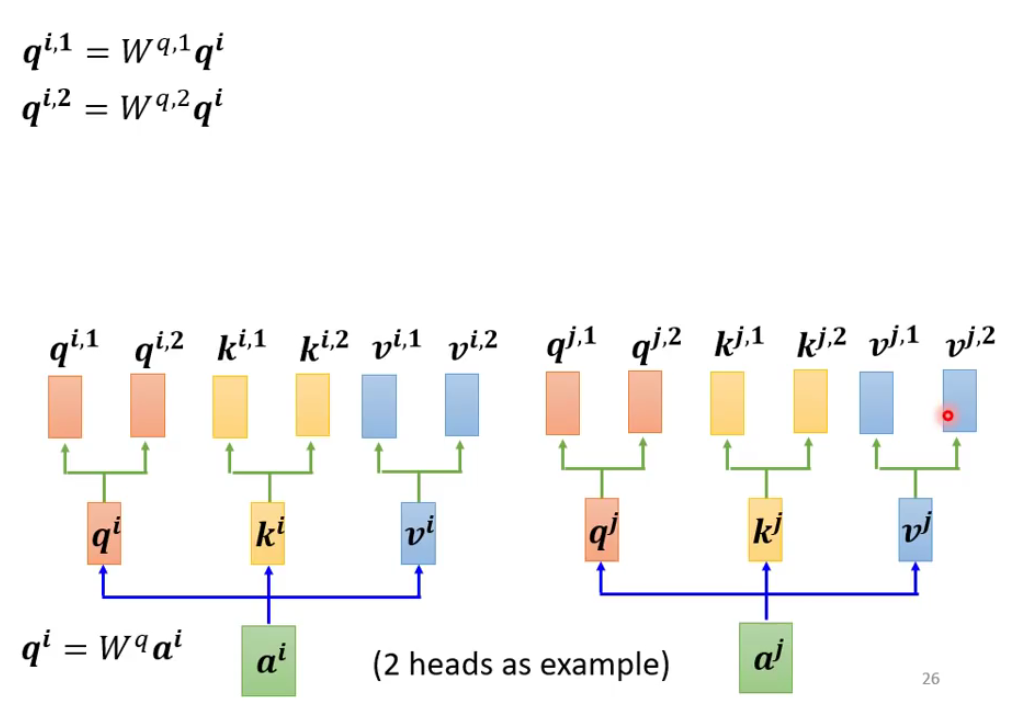

selfattention机制

╯^╰

Attention机制

不用GPU也能训练大模型?这家AI初创企业首推非Attention机制大模型《科创板日报》1月30日讯(记者 张洋洋) 在Transformer占大模型架构主流的背景下,国内一家AI初创企业正在试图撼动前者的主导地位。 近期,岩山科技旗下的AI初创公司岩芯数智发布了国内首个非Attention机制的大模型Yan,这是业内少有的非Transformer架构大模型。 Transformer是一...

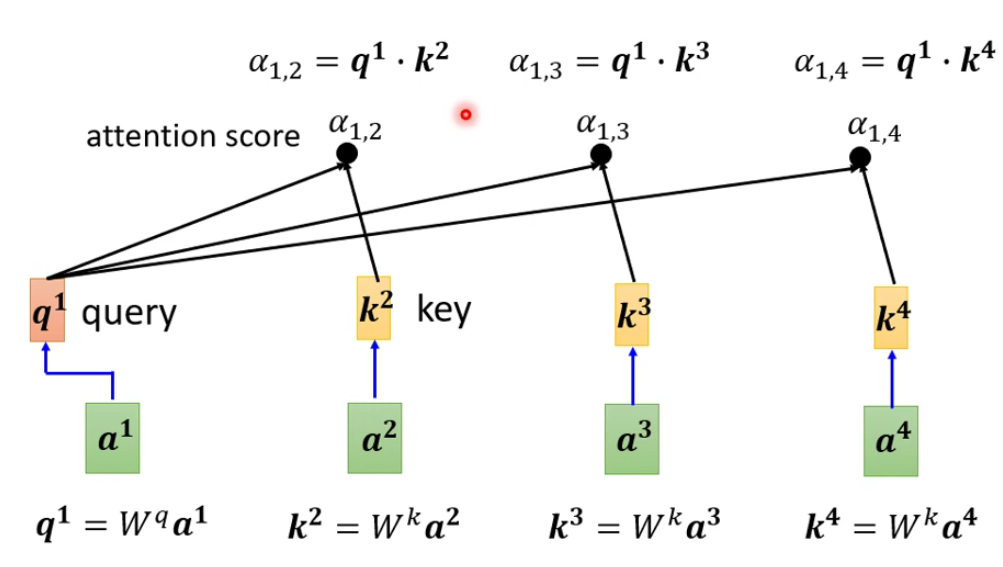

attention机制中的QKV

attention机制原理

摆脱Transformer依赖?这家AI初创公司推出国内首个非Attention机制大...正式发布了国内首个非Attention机制的通用自然语言大模型——Yan模型。作为行业内少有的非Transformer大模型,Yan模型用全新自研的“Yan架构”代替Transformer架构,用百亿级参数达成千亿参数大模型的性能效果——记忆能力提升3倍、速度提升7倍的同时,实现推理吞吐量的5倍提...

attention机制的作用

˙▂˙

attention机制和transformer

国内首个非Attention大模型发布!训练效率是Transformer的7倍作者 | 李水青编辑 | 心缘智东西1月25日报道,昨日,岩山科技旗下创企岩芯数智(Rock AI)推出国内首个非Attention机制的大模型Yan,也是业内少有的非Transformer架构大模型。岩芯数智CEO刘凡平介绍,Yan是一个通用大语言模型,拥有相较于同等参数Transformer的7倍训练效率、5倍推理...

attention机制Matlab代码

岩山科技:岩芯数智团队正研发Yan 2.0大模型 将融合文字、音频、视频...中国财富通2月21日 - 岩山科技(002195)在互动平台上表示,公司始终关注AI领域的最新进展,并持续进行技术创新。2024年1月,公司旗下岩芯数智已在上海发布了完全自主研发的Yan 1.0大语言模型,该模型是国内首个非Attention机制的大模型,同时也是国内领先的非Transformer架构大模型...

⊙▽⊙ Transformer神经网络:GPT等AI大模型的基石Transformer神经网络模型仅基于注意机制(Attention Mechanisms),完全摒弃了循环和卷积的结构,以其独特的自注意力机制和并行计算能力,解决了传统模型在处理长序列时的长距离依赖问题和计算效率问题,从而在各种NLP任务中取得了优异的性能。本文既是深度学习系列的最后一篇,也...

?▽? 国内首个与ChatGPT不同机制的通用大模型发布,算力消耗缩减50%岩芯数智CEO刘凡平(来源:钛媒体App编辑)钛媒体App获悉,1月24日下午,国内AIGC企业上海岩芯数智人工智能科技有限公司(岩芯数智,RockAI)在上海发布了国内首个自研的非Transformer Attention机制的低算力通用自然语言大模型——Yan模型,记忆能力提升3倍、速度提升7倍,推理吞吐...

更像人脑的新注意力机制,让大模型屏蔽无关信息,准确率提高27%公众号 QbitAI关于大模型注意力机制,Meta又有了一项新研究。通过调整模型注意力,屏蔽无关信息的干扰,新的机制让大模型准确率进一步提升。而且这种机制不需要微调或训练,只靠Prompt就能让大模型的准确率上升27%。作者把这种注意力机制命名为“System 2 Attention”(S2A),它...

≡(▔﹏▔)≡

岩芯数智发布全新通用大模型,加速产业数智化升级本文转自:人民日报客户端沈文敏作为国内较早布局人工智能大模型的企业之一,上海岩芯数智近日正式发布国内首个非Attention机制的通用自然语言大模型——Yan模型。这也是业内少有的非Transformer架构大模型,拥有相较于同等参数Transformer的7倍训练效率、5倍推理吞吐、3倍记...

岩芯数智CEO刘凡平:大多数企业不愿负担大模型堆积算力带来的昂贵...凤凰网科技讯 (作者|任清)近日,岩芯数智召开“新架构,新模力”大模型发布会,正式发布了国内首个非Attention机制的通用自然语言大模型——Yan模型,这也是业内少有的非Transformer架构大模型。1月26日下午,凤凰网科技就Yan模型的相关问题采访了岩芯数智的CEO刘凡平,他指出,以...

坚果加速器部分文章、数据、图片来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知删除。邮箱:xxxxxxx@qq.com

上一篇:attention机制

下一篇:attention机制起源