attention是什么意思_attention是什么意思

*** 次数:1999998 已用完,请联系开发者***

≡(▔﹏▔)≡ ...年6月成立并于2024年1月推出首个非Attention机制的大模型Yan 1.0公司回答表示:公司旗下专注于AIGC大模型研发的上海岩芯数智人工智能科技有限公司于2023年6月成立。岩芯数智已于2024年1月推出了完全自主研发的Yan 1.0自然语言大模型,Yan 1.0是国内首个非Attention机制的大模型。岩芯数智团队目前正在研发Yan 2.0模型,Yan 2.0模型将会融合...

≥^≤

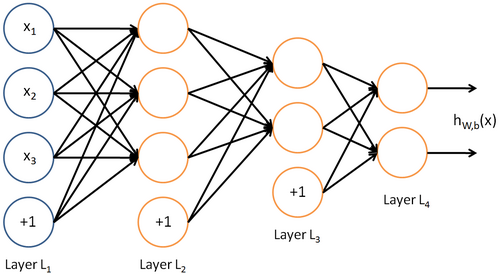

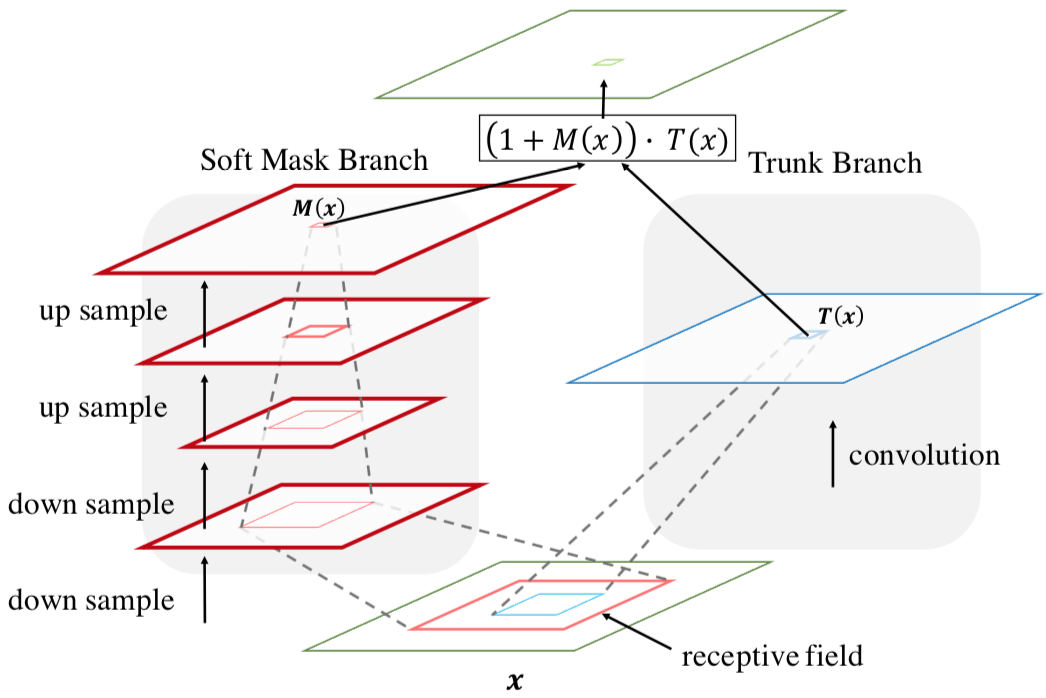

国内首个非Attention大模型发布!训练效率是Transformer的7倍作者 | 李水青编辑 | 心缘智东西1月25日报道,昨日,岩山科技旗下创企岩芯数智(Rock AI)推出国内首个非Attention机制的大模型Yan,也是业内少有... 岩芯数智对标业内的什么大模型?Yan有什么优势和劣势?刘凡平告诉智东西,Yan还没有真正对标谁,今天大家看到对比Transformer的一些数据是...

+▂+

⊙^⊙ 比Transformer快4成!Meta发布全新Megabyte模型,解决算力损耗硬伤编者按:本文来自微信公众号 新智元(ID:AI_era),编辑:Joey,创业邦经授权转载,头图来源摄图网Transformer无疑是过去几年内机器学习领域最流行的模型。自2017年在论文「Attention is All You Need」中提出之后,这个新的网络结构,刷爆了各大翻译任务,同时创造了多项新的记录。但Tran...

˙﹏˙

坚果加速器部分文章、数据、图片来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知删除。邮箱:xxxxxxx@qq.com

上一篇:attention是什么意思